Sådan bringer du AI-oversættelse til Edge-enheder med Microsoft Translator

I november 2016, Microsoft bragte fordelen af AI-powered maskinoversættelse, alias Neural Machine Translation (NMT), til udviklere og slutbrugere ens. Sidste uge Microsoft bragte NMT kapacitet til kanten af skyen ved at udnytte NPU'EN, en AI-dedikeret processor, der er integreret i Mate 10, Huaweis seneste flagskib telefon. Den nye chip gør AI-drevne oversættelser tilgængelige på enheden, selv i mangel af internetadgang, der gør det muligt for systemet at producere oversættelser, hvis kvalitet er på niveau med online-systemet.

For at opnå dette gennembrud samarbejdede forskere og ingeniører fra Microsoft og Huawei om at tilpasse neurale oversættelser til dette nye computermiljø.

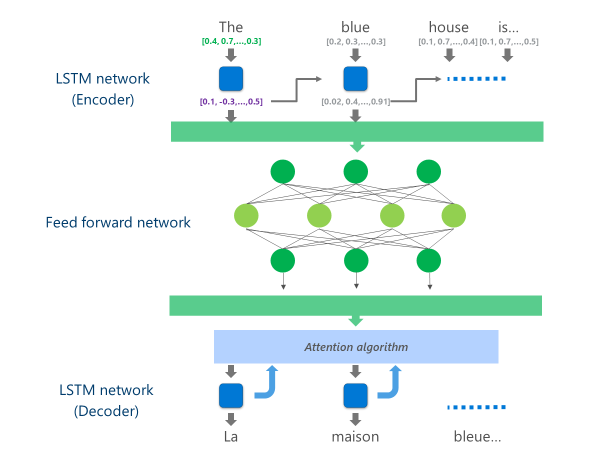

De mest avancerede NMT-systemer, der i øjeblikket er i produktion (dvs. anvendes i stor skala i skyen af virksomheder og apps), bruger en neurale netværksarkitektur, der kombinerer flere lag af LSTM-netværk, en opmærksomheds algoritme og et oversættelses-(dekoder) lag.

Animationen nedenfor forklarer, på en forenklet måde, hvordan dette multi-lag neurale netværk funktioner. Du kan finde flere oplysninger i afsnittet "Hvad er maskinoversættelse side"på webstedet Microsoft Translator.

I denne Cloud NMT-implementering bruger disse midterste LSTM-lag en stor del af computerkraften. For at kunne køre fuld NMT på en mobil enhed, var det nødvendigt at finde en mekanisme, der kunne reducere disse beregningsmæssige omkostninger og samtidig bevare, så meget som muligt, oversættelseskvaliteten.

Det er her, huaweis neurale behandlingsenhed (NPU) kommer i spil. Microsofts forskere og ingeniører benyttede sig af NPU, som er specielt konstrueret til at udmærke sig ved lav ventetid AI-beregninger, at aflaste operationer, der ville have været uacceptabelt langsomme til at behandle på de vigtigste CPU.

Gennemførelsen

Implementeringen, der nu er tilgængelig på Microsoft Translator-appen til Huawei Mate 10, optimerer oversættelsen ved at aflaste de mest beregningsintensive opgaver til NPU'EN.

Specifikt, denne gennemførelse erstatter disse midterste LSTM netværk lag af en dyb fnet-fremadrettet neurale netværk. Dybe feed-forward neurale netværk er kraftfulde, men kræver meget store mængder af beregning på grund af den høje konnektivitet blandt neuroner.

Neurale netværk er primært afhængige af matrix-multiplikationer, en operation, der ikke er kompleks fra et matematisk synspunkt, men meget dyrt, når de udføres i den skala, der kræves for en sådan dyb neurale netværk. Huawei NPU udmærker sig ved at udføre disse matrix-multiplikationer i en massivt parallel måde. Det er også ganske effektiv fra en magt udnyttelse synspunkt, en vigtig kvalitet på batteridrevne enheder.

På hvert lag af dette feed-forward-netværk beregner NPU både den rå neuron-output og den efterfølgende ReLu-aktiveringsfunktion effektivt og med meget lav ventetid. Ved at udnytte den rigelige høj hastighed hukommelse på NPU, det udfører disse beregninger parallelt uden at skulle betale omkostningerne for dataoverførsel (dvs., opbremsning ydeevne) mellem CPU og NPU.

Når det sidste lag af dette dybe feed-forward netværk er beregnet, har systemet en rig repræsentation af kildesproget sætning. Denne repræsentation er derefter fodret gennem en venstre-til-højre LSTM "dekoder" til at producere hvert målsprog ord, med den samme opmærksomhed algoritme, der anvendes i online-version af NMT.

Som Anthony Aue, en ledende Software Development Engineer i Microsoft Translator-teamet, forklarer: "at tage et system, der kører på kraftfulde Cloud-servere i et datacenter og kører det uændret på en mobiltelefon er ikke en holdbar løsning. Mobile enheder har begrænsninger i computerkraft, hukommelse og strømforbrug, som Cloud-løsninger ikke har. At have adgang til NPU, sammen med nogle andre arkitektoniske tweaks, tillod os at arbejde omkring mange af disse begrænsninger og til at designe et system, der kan køre hurtigt og effektivt på enheden uden at skulle kompromittere oversættelseskvalitet."

Implementeringen af disse oversættelses modeller på det innovative NPU-chipsæt tillod Microsoft og Huawei at levere neurale oversættelser på enheden til en kvalitet, der kan sammenlignes med cloud-baserede systemer, selv når du er slukket for nettet.